中国银行信息科技运营中心(上海)总经理 宋立

过去几十年间,我国商业银行数据中心在不断契合时代金融需求变化,助推金融科技创新的过程中积极引入先进的管理理念和信息技术提升自身发展水平,在绿色、智能和安全建设方面取得了令人瞩目的成绩。本文将在回顾我们商业银行数据中心发展历程和所取得丰硕成果的基础上,针对现阶段存在的问题,对比当前国际先进数据中心,剖析新基建背景下我国商业银行数据中心的建设与发展。

一、我国商业银行数据中心建设历程

上世纪80年代中期,我国商业银行从会计电算化起步逐步实现了地市、省区的信息集中处理,但是由于受到银行管理体制和通信条件等因素限制,往往在省、市分行都建有一个或多个信息处理中心。一家银行有几百甚至上千个信息处理中心的情况十分普遍。

上世纪90年代至21世纪初,为应对全球化的挑战我国商业银行开始了大规模的体制改革,通过数据大集中的方式将全国及海外分散的IT系统集中到数据中心运营,历经物理集中、逻辑集中、数据集中、应用集中四个不同阶段,实现了核心银行系统的升级替换,建立了具有快速应变能力的技术支撑体系,实现业务及IT的集中管理和流程再造,完成向现代化商业银行转型。各商业银行在数据集中的同时,为有效化解数据集中带来的IT风险,保持业务不间断运行,依照相关监管要求,逐步建设了两地三中心的IT基础设施和运营体系,确保在极端灾难情况下能够恢复对外服务。

近年来,为应对互联网金融的不断冲击、保持市场竞争力,商业银行积极拥抱金融科技,开始了以体验为核心、以数据为基础、以技术为驱动的数字化转型之路。商业银行数据中心(以下简称“数据中心”)结合集中式架构稳定一致性的特点,以及分布式架构动态调整、迭代更新、弹性扩容的特性,开始从传统数据中心逐步演化为多地多活云数据中心。通过建设面向大数据、区块链、人工智能等新技术应用的基础设施,为敏捷响应业务生态场景提供支撑。数据中心进入双模(稳态+敏态)运营模式的新阶段。

随着数据中心规模的不断扩大,安全防护保证业务连续性的要求日益提高,传统的运维模式无法满足多地多活云数据中心运维的需要。国家新型基础设施建设(以下简称“新基建”)战略的实施为新型数据中心建设带来了更广阔的发展空间。

二、新基建背景下我国商业银行数据中心加快绿色、智能、安全建设步伐

近年来,国家发展战略提出了加强包括数据中心在内的新型基础设施建设。基础设施具备公共性、基础性、强外部性的特征,提供如水电一样的基础服务,将全面重塑工业时代形成的生产关系,释放数字生产力所蕴含的巨大能量。

数据中心是以数据为基本管理对象,融合互联网服务、云计算、区块链、人工智能等新技术于一体,成为集数据、算力、算法三要素于一身的数据基础设施,是新型基础设施的基础,是数字经济的“黑土地”。

在新基建浪潮下,商业银行数据中心不仅仅是传统意义上的存放计算、存储及网络设备的机房,更需要秉承绿色、智能、安全的设计思路,在IT架构、运维模式、空间布局方面都要适应新兴技术带来的变化。构建面向服务的架构,保证业务连续性,防范网络安全风险。

1.提升数据中心绿色节能水平

数据中心属于高能耗部门,与国际先进的数据中心相比,我国商业银行的数据中心存在规模偏小、布局不合理、能效水平低等问题,PUE等能效指标仍然偏高。《关于加强绿色数据中心建设的指导意见》指出要引导数据中心走高效、清洁、集约、循环的绿色发展道路。因此数据中心建设要坚持绿色发展理念,运用创新技术手段,在机房选址、供电架构、制冷技术气流组织以及IT设备选型与IT架构等方面降低能耗。

(1)数据中心选址

新建大型云数据中心的选址要综合考虑交通、电力、地理位置、地方政策、气候等诸多因素。数据中心选址上偏向选择年平均气温低的高纬度地区或高海拔地区,充分利用海湾、河流冷水资源及山洞等地形优势,提升年均自然冷却天数,从而减少空调设备的能耗。同时,也需考虑倾向风电、太阳能发电和水力发电资源丰富地区,尽量减少化石能源的利用。

(2)供电架构

供电架构是数据中心基础设施建设的重点。在电源选择上,采用效率更高的高频UPS取代传统工频UPS及模块化UPS及休眠技术,进一步有效提高UPS电源效率;采用高压直流HVDC技术,特别是“市电直供+HVDC离线”技术,进一步降低电力系统本身能耗;采用高压油机、飞轮UPS、巴拿马电源等电源设备,也有助于降低基础设施设备耗能。在位置摆布上,变压器抵近机房安装,也能有效减少线路损耗。采用储能技术,能更有效平衡峰谷电力负荷,提高电网效能。

(3)制冷技术及气流组织

制冷能耗是数据中心影响PUE最重要的因素。当前新建数据中心大多在冷源上选择效率更高的水冷技术,替代传统风冷直膨制冷技术,配合冰水蓄冷等技术进一步降低能耗支出。随着国家对数据中心PUE指标要求日趋严格,采用自然冷却的板换、直冷、直接/间接蒸发冷却等技术更是在新建数据中心蓬勃发展。在末端设备上,列间空调、制冷背板、顶置冷却等贴近热源技术,通道封闭、盲板封闭等气流组织方式,都能有效提升制冷效率,降低PUE。

(4)IT设备选型与IT架构

选择单位能耗上IT产能更高的IT设备,如闪盘磁盘阵列等,是降低数据中心能耗的重要手段。选择能在更高温度条件下安全工作的高温服务器,可以将制冷系统工作温度值提高,从而有效降低制冷能耗。选择冷却效率更高的液冷服务器,更能进一步降低机房能耗。通过服务器虚拟化技术,提高服务器的单位使用效率,能有效降低数据中心物理服务器规模,节省投资和能耗。

2.构建自动化、流程化、平台化、智能化的运维体系

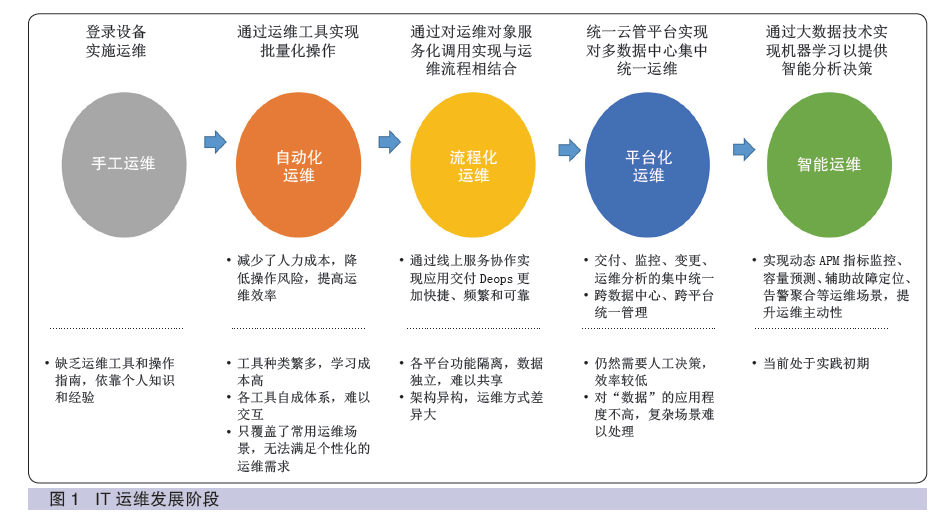

面对日益增长的运维规模,依靠传统的手工运维模式不仅低效,而且消耗了大量的人力资源。因此数据中心纷纷结合自身特点打造独具特色的集自动化、流程化、平台化、智能化于一体的运维平台,实现“事前智能预警、事中快速定位处置、夜间无人值守、远程集中管理”等目标。IT运维发展阶段如图1所示。

运维自动化强调利用自动化工具来实现大规模和批量化的自动化运维,能极大地减少人力成本,降低操作风险,提高运维效率。

运维流程化就是通过将运维对象和过程发布为一套服务,与运维管理流程结合。改变以往通过文档、邮件等线下协作方式,通过数据建模、流程编排、服务联动来完成线上合作,从而实现构建、测试、发布软件更加快捷、频繁和可靠,提升全生命周期端到端流程流转质效。

运维平台化就是构建统一云管平台实现对多数据中心集中统一运维,实现交付、监控、变更、运维分析的集中统一,实现跨私有IaaS/PaaS平台、大数据平台、数据仓库、容器平台等敏态环境和集中式架构的稳态环境的多数据中心统一管理能力。

运维智能化是指在云平台和大数据平台的基础上通过人工智能算法,自动地从海量运维数据中学习并总结规则作出决策的运维方式,最后执行自动化脚本以实现对系统的整体运维,实现包括动态APM指标监控、容量预测、辅助故障定位、告警聚合等运维场景,提升运维主动性。

3.强化数据中心安全运营能力

落实网络安全等级保护2.0标准。为了适应现阶段网络安全的新形势、新变化以及新技术、新应用发展的要求,数据中心按照网络安全等级保护2.0标准对信息基础设施开展定级备案、等级评测、建设整改。按照新标准中“基本要求、设计要求和评测要求”,建立统一的分级分类框架,形成了“网络通信安全”“网络边界安全”“网络计算安全”和“安全管理中心”,实现数据中心三重防护体系结构。对关键信息基础设施实行重点保护,进一步提升关键信息基础设施安全。

减少外部依赖,提升自主运维能力。国家大力发展以自主CPU和操作系统为代表的自主基础软硬件信息技术与产业体系,有助于减少数据中心对国外厂商的依赖,缓解日益严峻的信息安全问题。数据中心需要在此基础上培养一批懂设备、懂系统、懂运维、懂开发的全栈式人才队伍,减少对外部厂商的依赖,进一步提升自主运维能力,把安全牢牢控制在自己的手中。

构建灾难恢复预案应对金融信息化风险。数据中心按照“统筹规划、资源共享、平战结合”的灾备工作原则,结合主动性灾备维护经验,借鉴国际先进管理理念,建立独具特色的灾难恢复预案体系,开展以真实灾难场景为导向的全场景、全时段、全方位演练,确保在灾难发生时能迅速接管生产,筑牢业务连续性的最后一道防线。

强化云平台安全建设。针对云安全联盟提出的安全问题,数据中心需要加强云平台的认证与权限分配,避免服务劫持、防止服务滥用;加强计算、存储、网络等资源的隔离使得租户在使用服务时互补干扰;加强可用性安全性监控,确保系统稳定运行,减少集中性风险,减少恶意入侵;加强数据保护,运用数据加密,完善备份恢复机制,进行细粒度的数据访问控制。

三、新基建背景下数据中心发展展望

世界经济数字化转型是大势所趋,数据中心未来的发展需要抓住新基建的政策红利,不断夯实商业银行数字化发展基础。回顾数据中心从分散到集中再到分布式云化的发展历程不难发现,数据中心的螺旋式发展是业务需求、政策导向和信息科技进步共同驱动的结果。

从新技术应用上看,需要将IT作为整个科技转型的出发点,在业务中植入科技基因,从客户的视角去洞察需求,赋能业务发展。数据中心要前瞻性思考,全局性规划、高标准建设,坚持创新、绿色和安全等新发展理念,积极拥抱大数据、人工智能、物联网、区块链、5G等新兴技术,使之成为有力支撑数字化转型升级的数据中枢、算力载体,成为推动业务发展的重要基石。

从建设布局上看,一方面数据中心资源将逐步整合,呈现规模化、高密度的发展趋势,通过采用标准化和预制模块化建设模式,缩短建设周期,实现快速部署,以缓解数据爆发带来的算力压力;另一方面需要在靠近物或者数据源头的网络边缘侧建设边缘数据中心提供边缘计算能力,以适应超密度、高带宽和低时延的业务场景。“云计算+边缘计算”的新型数据处理模式将出现大量小型的边缘数据中心,在边缘计算、云计算以及网络之间实现云网协同、云边协同和边边协同。

从运维模式上看,在智能运维的基础上,需要基于交付链(Dev/Test/Ops)进行全局优化,打破职能型组织架构的能力边界,构建具备敏捷实时、无缝连接的多渠道银行服务能力的运营体系,实现IT运维向IT运营的跨越。

|